How ZeroGuess AI Thinks Wie ZeroGuess AI denkt

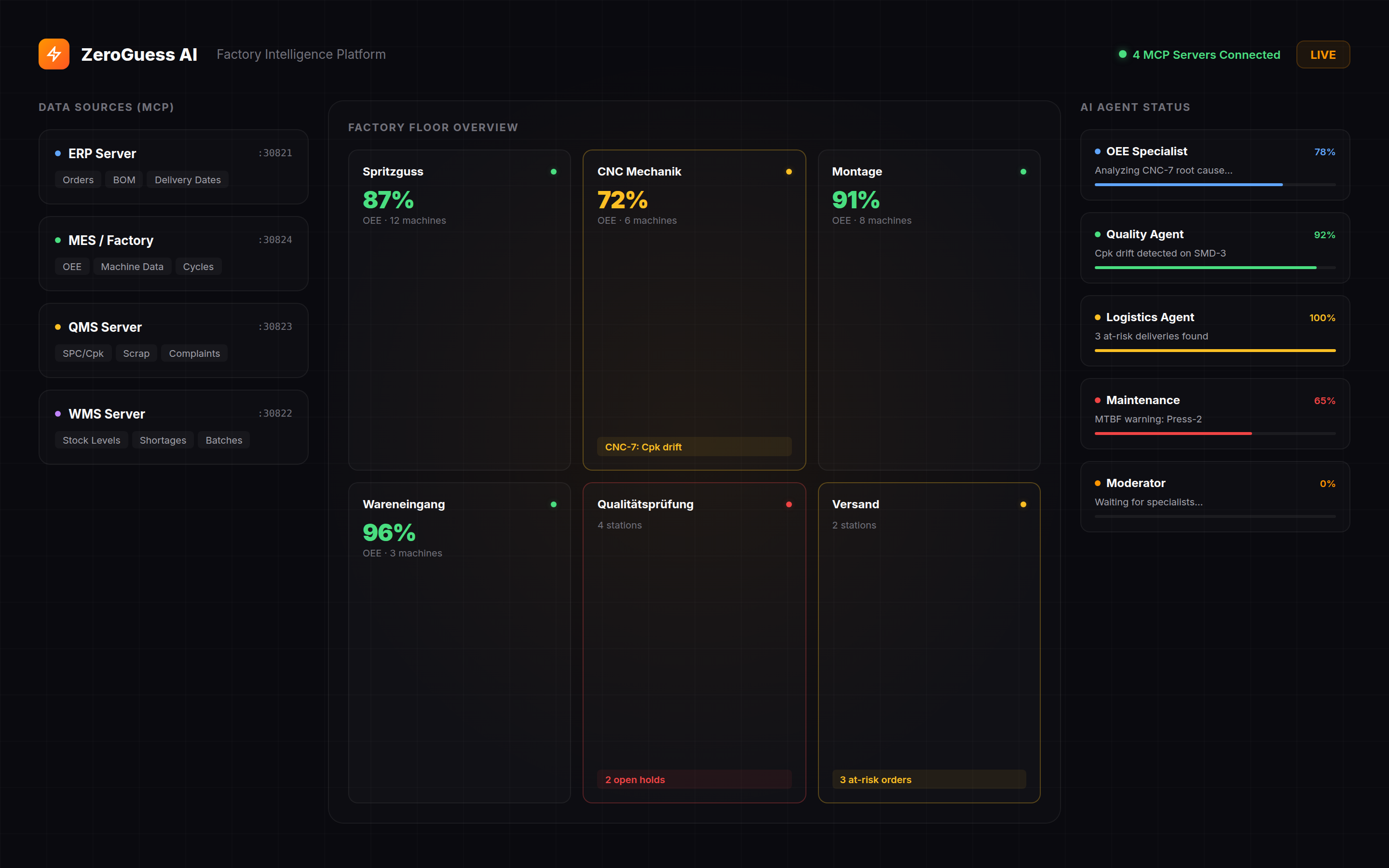

An Industry 4.0 multi-agent architecture where AI specialists debate, challenge, and converge on smart factory insights — the way a team of experts would. Eine Industrie-4.0-Multi-Agenten-Architektur, in der KI-Spezialisten debattieren, hinterfragen und sich auf Smart-Factory-Erkenntnisse einigen — wie ein Team von Experten.

3-Round Debate Protocol 3-Runden Debattenprotokoll

Not a single model guessing. A structured debate where specialists analyze, question, and refine — just like a real expert team. Kein einzelnes Modell, das rät. Eine strukturierte Debatte, in der Spezialisten analysieren, hinterfragen und verfeinern — wie ein echtes Expertenteam.

Parallel Analysis Parallele Analyse

5–6 specialist agents query all data sources simultaneously. Each builds an independent assessment from their domain: production, quality, logistics, maintenance, finance. No shared context yet — preventing groupthink. 5–6 Spezialisten-Agenten fragen alle Datenquellen gleichzeitig ab. Jeder erstellt eine unabhängige Bewertung aus seiner Domäne: Produktion, Qualität, Logistik, Instandhaltung, Finanzen. Noch kein gemeinsamer Kontext — verhindert Gruppendenken.

Moderated Discussion Moderierte Diskussion

A moderator agent reads all findings, identifies knowledge gaps, and asks targeted follow-up questions. It triggers deep-dive MCP queries to fill blind spots — for example, fetching tool change history when OEE and quality findings point to the same machine. Ein Moderator-Agent liest alle Ergebnisse, identifiziert Wissenslücken und stellt gezielte Rückfragen. Er löst Deep-Dive MCP-Abfragen aus — z.B. Werkzeugwechsel-Historie abrufen, wenn OEE- und Qualitätsergebnisse auf dieselbe Maschine zeigen.

Debate & Consensus Debatte & Konsens

The moderator drafts a report. Specialists critique it in parallel — challenging assumptions, adding context, flagging missing data. The moderator incorporates feedback and produces the final consensus report with prioritized actions. Der Moderator erstellt einen Entwurf. Spezialisten kritisieren parallel — hinterfragen Annahmen, ergänzen Kontext, markieren fehlende Daten. Der Moderator integriert Feedback und erstellt den finalen Konsensreport mit priorisierten Maßnahmen.

4 Data Sources via MCP Protocol 4 Datenquellen über MCP-Protokoll

The Model Context Protocol connects agents to all Industrial IoT and factory systems simultaneously — enabling real-time production monitoring without ETL pipelines, data warehouses, or batch jobs. Das Model Context Protocol verbindet Agenten mit allen IIoT- und Fabriksystemen gleichzeitig — ermöglicht Echtzeit-Produktionsüberwachung ohne ETL-Pipelines, Data Warehouse oder Batch-Jobs.

ERP

Orders, BOM, delivery dates, material master, production scheduling, customer data Aufträge, Stücklisten, Liefertermine, Materialstamm, Produktionsplanung, Kundendaten

MES / Fertigung

OEE hourly, machine status, downtime events, process parameters, cycle times OEE stündlich, Maschinenstatus, Stillstandsereignisse, Prozessparameter, Zykluszeiten

QMS

SPC data, Cpk values, scrap rates, notifications, cavity balance, complaints SPC-Daten, Cpk-Werte, Ausschussraten, Meldungen, Kavitätenbalance, Reklamationen

WMS

Inventory levels, warehouse movements, material allocation, shortage detection Lagerbestände, Lagerbewegungen, Materialzuordnung, Fehlmengenerkennung

Built With Production-Grade Open Source Gebaut mit produktionsreifem Open Source

Every core component is open source — zero license costs. Built for Industry 4.0 environments where you own the stack and control the roadmap. Jede Kernkomponente ist Open Source — keine Lizenzkosten. Gebaut für Industrie-4.0-Umgebungen, in denen Sie den Stack besitzen und die Roadmap bestimmen.

LangGraph Orchestration LangGraph-Orchestrierung

State-machine based agent orchestration for smart factory intelligence. Each agent follows a 6-phase pattern: data loading, deep analysis, problem identification, LLM analysis, action generation, and output formatting — including predictive maintenance triggers. Zustandsmaschinenbasierte Agenten-Orchestrierung für Smart-Factory-Intelligenz. Jeder Agent folgt einem 6-Phasen-Muster: Datenladung, Tiefenanalyse, Problemidentifikation, LLM-Analyse, Aktionsgenerierung und Ausgabeformatierung — einschließlich Auslöser für vorausschauende Wartung.

Local LLM Inference Lokale LLM-Inferenz

Qwen 2.5 72B runs on 5× NVIDIA RTX 3060 via llama.cpp. No data leaves your network. Full inference happens on your hardware — zero external API calls. Qwen 2.5 72B läuft auf 5× NVIDIA RTX 3060 via llama.cpp. Keine Daten verlassen Ihr Netzwerk. Die gesamte Inferenz läuft auf Ihrer Hardware — null externe API-Aufrufe.

Externalized Prompts Externalisierte Prompts

All LLM prompts live in markdown files with template variables. Domain experts can tune prompts without touching code. Hot-reload in development, cached in production. Alle LLM-Prompts liegen in Markdown-Dateien mit Template-Variablen. Domänenexperten können Prompts anpassen, ohne Code zu ändern. Hot-Reload in der Entwicklung, zwischengespeichert in der Produktionsumgebung.

Langfuse Observability Langfuse-Observability

Full tracing of every agent run: token usage, latency, prompt/response pairs, MCP tool calls. Debug agent behavior at the individual step level. Vollständiges Tracing jedes Agentenlaufs: Token-Verbrauch, Latenz, Prompt/Response-Paare, MCP-Tool-Aufrufe. Agent-Verhalten auf Einzelschrittebene debuggen.

See the Architecture In Action Erleben Sie die Architektur Live

Watch agents debate in real-time on a live factory simulation. Beobachten Sie die Agenten-Debatte in Echtzeit auf einer Live-Fabriksimulation.